クローラーとは?仕組みやSEOにおけるインデックス対策について

クローラーとは?仕組みやSEOにおけるインデックス対策について

今すぐ試せる、CVR改善リストを無料配布中!

CVRを今すぐ改善したい担当者様へ。業界別のCVR平均値をもとに、CVR改善ポイントを15個リストアップした資料をご用意しました。この後の業務からぜひご活用ください。

クローラーはWebページを巡回し情報を取得するためのプログラムです。運営しているWebサイトにクローラーが訪れ、適切に情報を検索エンジンに持ち帰ってもらうことがSEOの第一歩となり、クローラーの訪れやすさ、サイト内の巡回のしやすさ(クローラビリティ)はSEOに大きな影響を及ぼします。

この記事ではクローラーやインデックスの仕組み、クローラビリティを向上させる方法について解説します。またインデックスの確認やクローラーを巡回させない方法についても紹介するので、最後までご覧ください。

関連記事:SEOとは何か? メリットやすぐにできる対策方法を初心者向けにわかりやすく解説!

なお、SEOにしっかり取り組みたい方は無料配布資料「SEOに強いサイトにするための制作・運用チェックシート36項目」もあわせてご活用ください。サイトの制作〜運用までの各フローにおいて必要なSEO施策を、漏れなく実行できているか確認できるチェックシートになります。下記より無料でダウンロードできます。

クローラーとは

クローラーとは、インターネット上のWebサイトにアクセスし、文章や画像のデータを取得し内容を解析するプログラムです。ここではGoogleなどの検索エンジンがどのようにしてWebサイトの情報を取得し整理しているのか、またクローラーにはどのような種類があるのかについて解説します。

検索エンジンとクローラーの仕組み

検索エンジンがWebサイトの情報を取得し、検索結果へ反映させるまでには次の1〜4を繰り返します。

クローリング

パーシング

インデックス

スコアリング・クエリプロセス

まずWebサイトやWebページに辿り着くことを「クローリング」といいます。クローラーがWebページに辿り着いた後、そのページの情報を解析します(パーシング)。そして解析が終わったデータを変換し、検索エンジンのデータベースに保存する「インデックス」を行うのです。

検索エンジンのクローラーとしての役割としてはここまでですが、インデックスされたデータは検索エンジンの別のアルゴリズムがWebページごと、Webサイトごとに点数をつけ順位づけ(スコアリング)をします。

そして実際に検索エンジンのユーザーが検索した際には検索キーワードとインデックス情報、スコアリング情報を照らし合わせ、検索結果をリストアップする(クエリプロセス)、という一連の流れでWebページが検索結果に表示されるのです。

関連記事:SEOでのインデックスとは?仕組みやインデックスされない時の対処法も

クローラーがWebサイトを巡回するプロセス

クローラーがWebサイトやWebページを巡回するプロセスは主に次の3つです。

すでに登録されているデータベースから

Googleサーチコンソールからのリクエスト

リンク経由

この中でも特に重要なのが「クローラーはリンク経由でページを巡回する」ということ。他のサイトからのリンク(被リンク)が多いWebサイトはクローラーがよく巡回することになりますし、サイト内のリンクがきちんと整備されていてデータの構造がわかりやすいサイトはクローラーとしても効率よくサイト内部の情報を取得できるのです。

外部リンクや内部リンクは、クローラーにとって非常に重要な役割を担います。

関連記事:SEO外部対策とは?必要性や具体的な15の施策についても

関連記事:SEOの内部施策ですべき16のこと|目的とやり方を合わせて解説

クローラーの種類

検索エンジンのクローラーには次の4種類があります。

GoogleBot(Google検索のクローラー)

BingBot(Bing検索のクローラー)

その他検索エンジンのクローラー

検索エンジン以外のクローラー

日本でSEOを展開する際には、主に意識するべくはGoogleBotで、次点でBingBotとなります。というのも、日本におけるGoogle検索のシェアはGoogle・Yahoo!(内部アルゴリズムとしてGoogle検索を利用している)合わせて90%以上であり、Googleの検索エンジンの対策をすれば90%の検索に対応できるためです。

ただデスクトップパソコンでの検索に絞って考えるとGoogle検索のシェアは89%ほどとなり、対してBing検索は10%程度となるため、デスクトップからの来訪が多いWebサイトについてはBingの検索エンジンにも対応が必要になるケースもあります。

日本ではほとんど利用されませんが、韓国のNaverや中国のBaiduなどの海外の検索エンジンにもそれぞれクローラーがあります。またクローラーは検索エンジンだけのものではなく、AhrefsBotやSemrushBotなどのSEOツールが独自にクローラーを走らせている場合もあります。

クローラーはGoogle検索のクローラーだけではないことだけ、覚えておきましょう。

クローラーとSEOについて

クローラーがWebサイトに訪れることが、SEOの第一歩になることは上で説明した通りです。

ここではSEOに影響を及ぼす「クローラビリティ」について解説します。

クローラビリティの重要性

クローラビリティとは、クローラーの訪れやすさ、サイト内の巡回のしやすさを指します。

Google検索のデータベースには数千億のページが含まれ、1億GB以上の容量がページのインデックスに使われていると言われています。さらに新しいWebサイト・Webページが毎日のように生み出されている現代、データベースへのページ情報の保存と更新のためのクローラー巡回には膨大な費用が発生することは想像に難しくありません。

そのためクローラーが巡回しやすい設計の(クローラビリティの高い)サイトはスムーズなクローリングが可能なので、クローラー側のリソースを消費しにくく、クローリングの頻度が高い傾向にあります。クローラーの巡回頻度が高いということは、新しい記事や記事の更新がすぐに検索結果に反映されやすいことを指すので、SEO上有利となります。

クローラビリティの高いWebサイトを目指しましょう。

クローラビリティを向上させる7つの方法

クローラビリティを向上させる方法を7つ、紹介します。

サイトマップの送信

URLの正規化

サイト構造の最適化

パンくずリストの設置

内部リンクの整備

ページの表示速度の改善

インデックス不要なページへのクローリングの拒否

1. サイトマップの送信

検索エンジン向けのサイトマップである「XMLサイトマップ」をGoogleサーチコンソール経由で送信しておくことで、クローラビリティの向上が期待できます。

XMLサイトマップはサイト内のページが検索エンジンにわかりやすいように記載されているサイトマップで、XMLサイトマップによって優先的にクローリングするページをクローラーに伝えることが可能です。

サイトマップ送信の方法はこちらの記事を参考にしましょう。

関連記事:Googleサーチコンソールの設定方法|使い方や見方についても

2. URLの正規化

URLの正規化とは、同じページのURL(「www.」ありの場合のURLとなし場合など)で、同じページを表示させることです。同じ役割のURLを別のページとして検索エンジンに認識させると、それだけ余計にクローラーのリソースを消費してしまいます。

正規化を行うことで、クローラビリティの向上を行いましょう。

3. サイト構造の最適化

サイト構造の最適化もクローラビリティ対策となります。

構造の最適化には次の2つの方向性があります。

トップページから2クリックで様々なページに辿り着ける構造にする

近いテーマの内容の記事を同じディレクトリに分ける

まずトップページから2クリックで様々なページに辿り着ける構造とすることで、クローラーが巡回しやすくなります。また2クリックで様々なページに辿り着けるようにするためにはトップページを整備する必要があり、内容が整理されるのでユーザーの使いやすさ向上も期待できます。

またテーマの近い記事を同じディレクトリに分けることで、クローラーに関連性を示しやすくなります。

関連記事:ディレクトリ構造はSEOで重要?最適化の際の7つの注意点も

4. パンくずリストの設置

パンくずリストとは、現在表示されているページのWebサイト内での位置を示すナビゲーションです。「home>カテゴリ>タイトル」といった順番で表されることが多く、例で言う「home」や「カテゴリ」部分にはテキストリンクが設定されており、リンクの役割を果たします。

このパンくずリストのリンクによってクローラーがページ同士の関連性などを把握しやすくなるので、ぜひ設定しましょう。

5. 内部リンクの整備

記事中に内部リンクのないページはグローバルメニューやパンくずリストなどの、どの記事にもあるような内部リンクだけになってしまい、クローラビリティを下げてしまいます。

文章中に関連性のあるテーマの記事へ自然な流れで内部リンクを設定することで、クローラーやユーザーの回遊をスムーズにすることができます。

ただし、ただ「内部リンクを増やせば良い」と闇雲に内部リンクを設置しても、クローラーのリソースをいたずらに消費してしまうので、逆効果。あくまで関連のある記事にのみ設置しましょう。

関連記事:内部リンクはSEOに必要?リンクの貼り方や注意点についても

6. ページの表示速度の改善

ページの表示速度もクローラビリティ向上には必要な対策です。

実際に「Google検索セントラル」にて次のような説明がされています。

サイトの速度を上げると、ユーザーにとっての利便性が向上するだけでなく、クロール頻度も高くなります。Googlebot では、速度に優れたサイトはサーバーが健全な状態であることを表すものと見なされるため、同じ接続の数でより多くのコンテンツの取得が可能になります。(Google検索セントラルより)

画像の圧縮やJavascriptの軽量化を行い、ページ表示速度の高速化を目指しましょう。

7. インデックス不要なページへのクローリングの拒否

画像のみのページやEEATの観点から明らかに質の低いコンテンツについては、クローリングの拒否を行いましょう。クローリングを行うページを絞ることで、必要なページに適切な評価を受けることが可能になります。

インデックスが不要なページの例は次のとおりです。

質の低いコンテンツ:EEATの観点から、検索ユーザーのためにならないと明らかに判断できるコンテンツ

サイト内の重複コンテンツ:サイトの中にある、同じようなテーマの記事

見られたくないページ、必要のないページ:サンクスページなど検索結果に載せたくないページ、会員限定ページやステージング環境のページなど外部に見せる必要のないページ

インデックスを確認する方法

インデックスされていることを確認するための方法は次の2つです。

「site:」コマンドの使用

Googleサーチコンソールの活用

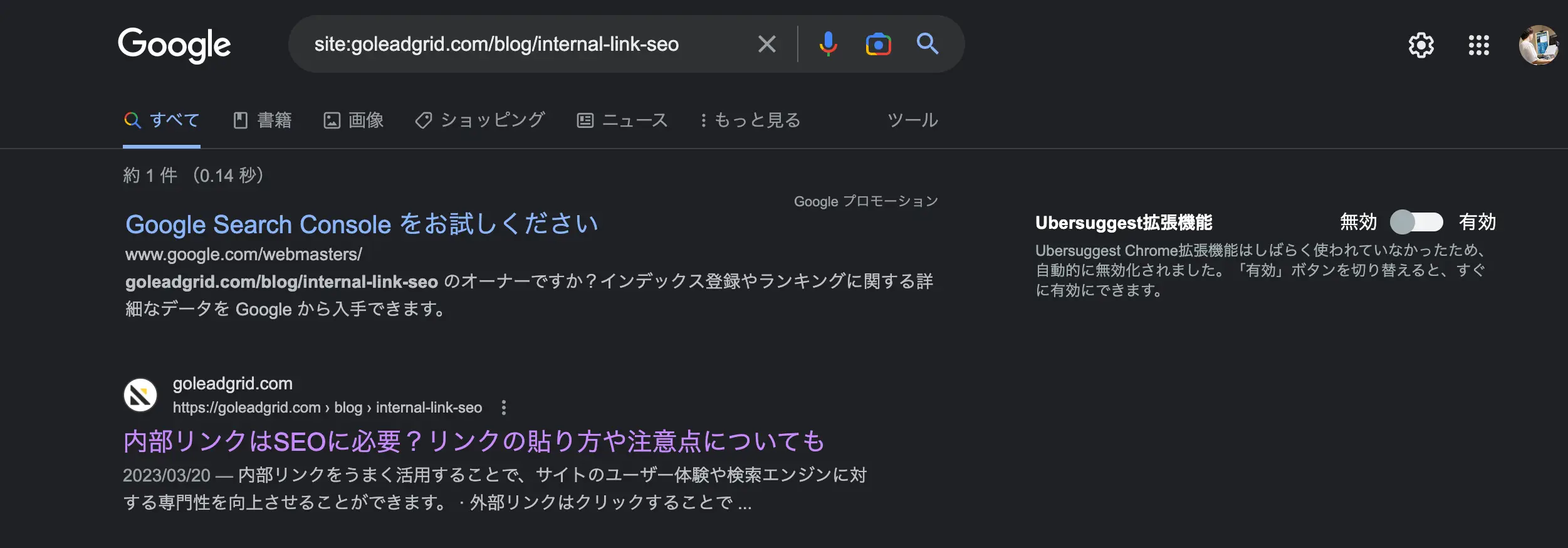

「site:」コマンドの使用

Google検索の検索画面にて「site:」コマンドを利用することで、インデックスの確認が可能です。「site:goleadgrid.com/blog/internal-link-seo」のように、「site:+調べたいページのURL(ドメインより後)」を入力します。検索結果に目的のページが出現すればインデックス済み、出現しない場合はインデックスされていないか、インデックスされているもののページの品質に問題があって検索結果に表示されていないかになります。

Googleサーチコンソールの活用

Googleサーチコンソールでもインデックスされているかどうかの確認が可能です。

Googleサーチコンソール上、左メニューに表示される「URL検査」から「チェックしたいページのURLを入力」により、確認しましょう。

無事インデックスされていると下のような画面になりますが、どこかに問題があると、その項目が赤色で表示されます。

クローラーの巡回頻度を上げる2つの方法

クローラーの巡回頻度を上げる方法は次の2つです。

質の高いコンテンツを頻度高めに公開する

Googleサーチコンソールからリクエストする

1. 質の高いコンテンツの公開頻度をできるだけ高める

できるだけコンテンツを一定の頻度で公開しましょう。コンテンツを定期的に公開することで、クローラーの巡回頻度を上げることができます。

しかし、ただ頻度を上げてコンテンツを公開すればいいというものではありません。「質の低いコンテンツ」と判断されてはその記事のインデックス登録に悪影響が及ぶほか、Webサイト全体のクロールの優先順位を大きく下げられてしまう可能性があります。

高い水準で質を一定に保てる範囲で、できるだけ頻度を高めて公開するようにしましょう。

2. Googleサーチコンソールからリクエストする

もう一つのクローラーの巡回頻度を上げる方法は、Googleサーチコンソールからリクエストする方法です。この方法は手動でクローリングをリクエストするため、比較的サイト運営者側がコントロールしやすい方法といえます(リクエストをすると必ず公開されるわけではありません)。

Googleサーチコンソールからリクエストする方法としては、次のとおりです。

画面左のメニューの「URL検査」から検索窓にクローリングをリクエストしたいURLを入力、エンターキーを押す

「URLがGoogleに登録されていません」と表示されるので「インデックス登録をリクエスト」をクリック

クローラーを巡回させない3つの方法

「インデックス不要なページへのクローリングの拒否」で紹介したようなページにクローラーを巡回させない方法は、主に次の3つです。

robot.txtの利用

noindexの利用

.htaccessの利用

robot.txtの利用

この方法は「robot.txt」というファイルにクローリングしないようにしたいWebページ(もしくはディレクトリ)を書き込みサーバーにアップロードすることで、クローラーにクローリングをしないように指令を送る方法です。

robot.txtとは「robot.txt」がファイル名のテキストファイルのことで、クローラーに動作の制御を命令するためのファイルです。サーバーにrobot.txtファイルがない場合は新規で作成する必要があります。

なおrobot.txtファイルに記載する内容例としては、以下の通りです。

User-agent: * Disallow: /*ディレクトリ名*/「User-agent: *」は全てのbot(GoogleBotだけでなく、BingBotや画像検索系のBot、その他サービスのbotなど)に対してファイルの内容を有効に作用させることを指示し、「Disallow: /*ディレクトリ名*/」でクローリングを許可しないディレクトリやWebページを指示します。

なお*ディレクトリ名*の部分を「marketing」「seo」など、クローリングをブロックしたいディレクトリの名前に変更して使用ください。またディレクトリではなく特定のWebページのクローリングをしないように指示したい時は、「seo/internal-seo/」などの特定のWebページに置き換えて記述しましょう。

ちなみにrobot.txtファイルをアップロードする場所はWebサイトのルートディレクトリ(トップページのファイルがある場所)です。

noindexの利用

noindexはクローリング自体は許可するものの、検索結果に掲載する情報としてインデックスすることを許可しないことを指示するものです。

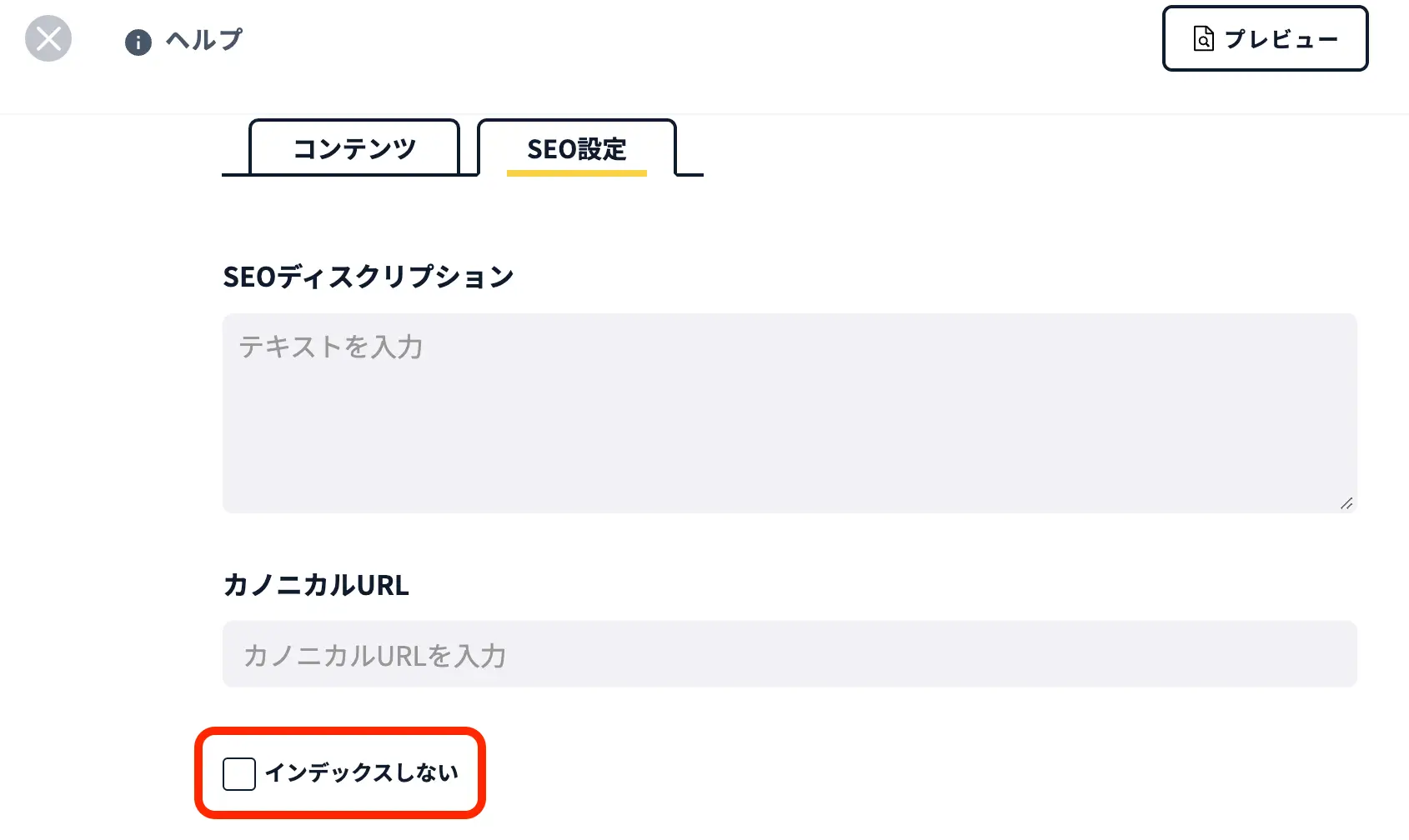

LeadGridやWordPressなどのCMSであれば、投稿ページ内などで「noindex」を指示する機能があるので、3つの中で一番手軽な方法でもあります。

▲LeadGridでのnoindex設定例

.htaccessの利用

.htaccessとはWebサーバーの動作をコントロールする設定用のファイルで、ページをパスワード保護する「アクセス制限」のほか、404ページや301リダイレクトの際にもこのファイルで設定を行います。

.htaccessを利用したクローリングのブロックは、このファイルのアクセス制限ができる機能を利用してクローリングをサーバーレベルでブロックするようなイメージとなります。

アクセス制限の設定には「.htaccessファイル」と「.htpasswordファイル」の2つが必要です。

.htaccessファイルには以下の4行を追記します。

AuthType Basic

AuthName “パスワード認証画面に表示させたいメッセージ (例:IDとパスワードを入力)”

AuthUserFile .htpasswordの場所(例:/home/ドメイン名/フォルダ名/.htpassword)

require valid-user.htpasswordファイルには次を記載します。

ID(例:admin):Pass(例:0123)ユーザー認証の際に必要なIDとパスワードで一対になるようにします。

LeadGridで記事コンテンツ作成に集中しよう

この記事ではSEOでのクローラーの仕組みや種類、インデックスされているかどうかの確認方法について解説しました。

この記事で紹介したクローラビリティ向上のための対策を確認し、Webサイト運営に役立てましょう。

LeadGridは株式会社GIGがWebサイト制作の際に利用するCMSで、一般向けのブログサービスのようなブログ機能の使い勝手に定評があります。

LeadGridは内部SEOに強く、クローリングなどについてあまり考えず、記事コンテンツ作成に集中ができるような設計になっています。もちろん内部リンクを意識したSEOに強いキーワード設計を行い、記事中に内部リンクを設置するなどの運用面で気をつけていく必要もありますが、Webサイト制作の際LeadGridチームにてキーワード設計や記事作成についても請け負っているので、ご安心ください。

SEOの基盤が整いやすく、記事コンテンツの作成も気軽に行えるLeadGridで、SEOに強いWebサイトを目指しましょう。

今すぐ試せる、CVR改善リストを無料配布中!

CVRを今すぐ改善したい担当者様へ。業界別のCVR平均値をもとに、CVR改善ポイントを15個リストアップした資料をご用意しました。この後の業務からぜひご活用ください。

LeadGrid BLOG編集部は、Web制作とデジタルマーケティングの最前線で活躍するプロフェッショナル集団です。Webの専門知識がない企業の担当者にも分かりやすく、実践的な情報を発信いたします。

関連記事

-

ホームページの問い合わせを増やすには?フォームの作り方から改善策まで解説

- # Webマーケティング

- # Webサイト

-

Web集客が得意な代行会社7選|選び方やメリット・デメリットを紹介

- # Webマーケティング

-

Webサイト改善コンサルティング10選!選び方から費用相場まで解説

- # Webマーケティング

- # Webサイト

-

SNS運用代行とは?依頼できる内容やメリット・おすすめの会社を紹介

- # Webマーケティング

-

TikTok採用とは?メリット・デメリットや成功事例を詳しく解説

- # 採用サイト

-

【比較表付き】MAツールおすすめ13選!選び方や主な機能についても解説

- # Webマーケティング

- # MAツール

Interview

お客様の声

-

SEO・更新性・訴求力の課題を同時に解決するため、リブランディングとCMS導入でサービスサイトを刷新した事例

ジェイエムエス・ユナイテッド株式会社 様

- # サービスサイト

- # 問い合わせ増加

- # 更新性向上

Check

Check -

「SEOに閉じないグロースパートナー」へ想起転換したコーポレートサイト刷新の事例

株式会社LANY 様

- # コーポレートサイト

- # リブランディング

- # 採用強化

Check

Check -

企業のバリューを体現するデザインとCMS刷新で情報発信基盤を強化。期待を超えるサイト構築を実現した事例

株式会社エスネットワークス 様

- # コーポレートサイト

- # 更新性向上

Check

Check -

採用力強化を目的に更新性の高いCMSを導入し、自社で自由に情報発信できる体制を実現した事例

株式会社ボルテックス 様

- # 採用サイト

- # 採用強化

- # 更新性向上

Check

Check

Works